РОССИЙСКАЯ ФЕДЕРАЦИЯ ФЕДЕРАЛЬНАЯ СЛУЖБА ПО ИНТЕЛЛЕКТУАЛЬНОЙ СОБСТВЕННОСТИ |

(19)

RU

(11)

2 591 029

(13)

C1 | |||||

| ||||||

| Статус: | не действует (последнее изменение статуса: 14.08.2021) |

| Пошлина: | учтена за 3 год с 14.02.2017 по 13.02.2018. Возможность восстановления: нет. |

|

(21)(22) Заявка: 2015104844/28, 13.02.2015 (24) Дата начала отсчета срока действия патента: Приоритет(ы): (22) Дата подачи заявки: 13.02.2015 (45) Опубликовано: 10.07.2016 Бюл. № 19 (56) Список документов, цитированных в отчете о поиске: RU 2497175 C1, 27.10.2013. RU 2013126754 A, 20.12.2014. US 2013027555 A1, 31.01.2013. WO 1997004417 A1, 06.02.1997. Адрес для переписки: |

(72) Автор(ы): (73) Патентообладатель(и): |

(54) СПОСОБ ПОЛУЧЕНИЯ НА ЛЕТАТЕЛЬНОМ АППАРАТЕ (ЛА) УЛУЧШЕННОГО ИЗОБРАЖЕНИЯ ПОДСТИЛАЮЩЕЙ ПОВЕРХНОСТИ

(57) Реферат:

Изобретение относится к способам моделирования, анализа и обработки изображений и может быть использовано в системах повышения ситуационной осведомленности пилотов летательных аппаратов (ЛА), а также в системах внешнего ориентирования и распознавания по видеоинформации в мобильных роботах и в беспилотных ЛА. Сущность изобретения заключается в том, что на ЛА получают улучшенное изображение подстилающей поверхности, основанное на совмещении в бортовом компьютере ЛА сенсорной видеоинформации, полученной с помощью штатной видеокамеры ЛА, и синтезированной видеоинформации, сформированной по априорно заданной пространственной модели местности, введенной в память бортового компьютера. Технический результат - простота аппаратно-программной реализации за счет низкой вычислительной сложности алгоритма, а также расширение области его применения за счет использования произвольных устойчивых топологических особенностей и возможность уточнения показаний навигационных приборов, измеряющих положение и ориентацию ЛА, исключение пространственных искажений и потерь информации, связанных с геометрическими преобразованиями цифровых изображений, таких как поворот, сдвиг и растяжение/сжатие. 2 з.п. ф-лы, 7 ил.

Изобретение относится к способам моделирования, анализа и обработки изображений и может быть использовано в системах повышения ситуационной осведомленности пилотов ЛА, а также в системах внешнего ориентирования и распознавания по видеоинформации в мобильных роботах и в беспилотных ЛА.

Известен способ автоматического совмещения сенсорной и синтезируемой видеоинформации для авиационной системы комбинированного видения (см. Вестник компьютерных и информационных технологий, 2014, №7, http://www.vkit.ru/index.php/component/content/article/60-2014-07--july/267-008-013), где подобную задачу решают для конкретного класса изображений, на которых возможно автоматическое распознавание взлетно-посадочной полосы (ВПП) при помощи модифицированного проекционного преобразования Хафа. Уточнение параметров внешнего ориентирования осуществляют путем минимизации невязок условий коллинеарности центра проектирования виртуальной видеокамеры, опорных точек на синтезированном изображении и соответствующих им точек на сенсорном изображении. Однако надежное автоматическое распознавание ВПП по сенсорным изображениям подстилающей поверхности может быть реализовано, как правило, в простых метеоусловиях, когда возможен режим визуального пилотирования, поэтому данный способ имеет весьма ограниченные условия применения.

Для предлагаемого способа наиболее близким аналогом - прототипом является совмещение сенсорной и синтезированной информации в комбинированное изображение (см. патент США № US 7925117 с приоритетом от 27 июня 2006 года), в соответствии с которым на сенсорном изображении распознают топологические особенности (ТО) местности с перепадами яркости, образующими характерные фигуры, например область пересечения дорог, горный пик, изгиб реки, угол здания. Затем получают градиенты для окрестностей заданного размера вокруг пары ТО, извлекают соответствующие изображения градиентов из синтезированного изображения (проекции пространственной модели местности), формируемого исходя из определяемых по показаниям бортовых навигационных приборов ЛА (т.е. при наличии приборных ошибок) текущего положения и угловой ориентации бортовой видеокамеры (бортового сенсора) и ее технических характеристик, вычисляют центры тяжести градиентных изображений ТО для сенсорной и синтезированной пары ТО и невязки между соответствующими изображениями градиентов. На заключительном этапе применяют нелинейную трансформацию синтезированного изображения путем минимизации невязок между соответствующими изображениями градиентов, затем формируют результирующее комбинированное изображение путем суммирования сенсорного и обработанного в соответствии с данным способом синтезированного изображения.

Данный способ вносит пространственные искажения в результирующее изображение при микшировании сенсорной и синтезированной видеоинформации, так как привязку синтезированного цифрового изображения (изначально отличающегося от сенсорного изображения из-за формирования при наличии ошибок бортовых навигационных приборов) к сенсорному кадру осуществляют согласно найденным невязкам центров тяжестей контуров совмещаемых локальных особенностей, что для достаточно больших невязок существенно трансформирует синтезированную информацию. Кроме того, этот способ обладает недостатком, заключающимся в том, что поиск с последующим распознаванием локальных особенностей на сенсорном кадре производят без учета информации об устойчивых априорно известных ТО, отображенных в пространственной модели местности. Отмеченный недостаток может приводить к ошибочному совмещению изображений.

Задача изобретения заключается в обеспечении совмещения видеоинформации от бортового сенсора с синтезированной видеоинформацией без нелинейной пространственной трансформации последней и возможности дополнительного уточнения пространственного положения и ориентации ЛА.

Сущность изобретения заключается в том, что на ЛА получают улучшенное изображение подстилающей поверхности, основанное на совмещении в бортовом компьютере ЛА сенсорной видеоинформации, полученной с помощью штатной видеокамеры ЛА, и синтезированной видеоинформации, сформированной по априорно заданной пространственной модели местности, введенной в память бортового компьютера; в память бортового компьютера вводят алгоритм функционирования виртуальной видеокамеры, осуществляющий перспективное преобразование виртуальной модели местности на картинную плоскость с параметрами, соответствующими угловым размерам поля зрения и разрешению в эффективных пикселях штатной видеокамеры, а в каждый текущий момент времени в бортовой компьютер ЛА вводят соответствующую сенсорную видеоинформацию и информацию о пространственном положении штатной видеокамеры (широта, долгота, высота, углы ее ориентации), по которой определяют параметры перспективного проецирования местности, затем на основе этих данных по пространственной модели местности формируют соответствующее текущее синтезированное изображение, на котором определяют и отмечают местоположение не менее двух известных топологических особенностей (ТО), заданных в априорно введенной пространственной модели местности, затем на сенсорном изображении находят местоположения ТО, тождественных ТО, отмеченных на синтезированном изображении, после чего сопоставляют положения найденных ТО на сенсорном изображении и соответствующих ТО на синтезированном изображении, выявляют невязки расстояний между центрами соответствующих ТО и по выявленным различиям уточняют пространственное положение виртуальной видеокамеры за счет проведения процедуры минимизации функции суммарной невязки этих расстояний, затем производят временную фильтрацию уточненного пространственного положения виртуальной видеокамеры с учетом предшествующих уточненных значений, после чего формируют с помощью виртуальной камеры новое синтезированное изображение, а потом, суммируя сенсорное и новое синтезированное изображения, формируют микшированное представление подстилающей поверхности, которое и выводят на индикаторное устройство ЛА.

Кроме того, при получении изображений ТО, априорно заданных на пространственной модели местности, применяют линейную коррекцию динамического диапазона в окрестности центров ТО на сенсорном и синтезированном изображениях, а для временной фильтрации уточненных пространственных положений виртуальной видеокамеры используют процедуру фильтрации по Калману.

Техническим результатом при использовании предлагаемого способа является простота аппаратно-программной реализации за счет низкой вычислительной сложности алгоритма, а также расширение области его применения за счет использования произвольных устойчивых ТО и возможность уточнения показаний навигационных приборов, измеряющих положение и ориентацию ЛА путем реализации процедуры уточнения пространственного положения виртуальной видеокамеры. Предлагаемый способ гарантирует отсутствие пространственных искажений и потерь информации, связанных с геометрическими преобразованиями цифровых изображений, таких как поворот, сдвиг и растяжение/сжатие.

Ниже приведен пример реализации заявляемого способа получения на ЛА улучшенного изображения подстилающей поверхности. В предлагаемом примере в качестве априорно заданной информации используются следующие данные:

- Пространственная модель местности, представляющая собой массив вершин в трехмерном евклидовом пространстве, объединенных в грани, которые объединены в свою очередь в пространственные объекты (см., например, Шикин Е.В., Боресков А.В. Компьютерная графика. Полигональные модели. - М.: Диалог-МИФИ, 2001, с. 321). Каждой вершине или полигону соответствуют ее атрибуты: нормаль для освещения, цвет и текстурная координата для определения цвета закраски или области накладываемой текстуры данной вершины или полигона. К каждому объекту может прилагаться текстура и описание свойств его материала, задающая характер его освещения. Пространственная модель местности хранится в памяти бортового компьютера либо в виде базы данных отдельных участков местности, либо в виде набора файлов трехмерных моделей наземных объектов, подгружаемых в оперативную память бортового компьютера.

- Алгоритм функционирования виртуальной видеокамеры, реализующий матричное преобразование пространственной модели местности (см., например, Шикин Е.В., Боресков А.В. Компьютерная графика. Полигональные модели. - М.: Диалог-МИФИ, 2001, с. 220). Коэффициенты матричного преобразования - вещественные числа, которые вычисляют, исходя из характеристик штатной видеокамеры, таких как угловые размеры поля зрения и разрешение в эффективных пикселях, а также исходя из положения и ориентации штатной видеокамеры. Данное преобразование представляет собой произведение матриц поворота по трем углам ориентации в пространстве, матрицы сдвига и матрицы перспективного проецирования. При умножении всей совокупности вершин и их атрибутов из пространственной модели на матрицу преобразования пространственной модели с последующим ограничением области вывода такого же размера, что и размер сенсорного изображения, получают синтезированное изображение.

- Угловые поля зрения штатной видеокамеры.

- Разрешение в эффективных пикселях штатной видеокамеры.

- Значения погрешностей бортовых приборов, измеряющих положение и ориентацию ЛА.

- Координаты центров значимых ориентиров - топологических особенностей (ТО). В пространственной модели местности это могут быть углы зданий, точки пересечения дорог, вершины горных пиков или башен, изгибы берегов рек.

- Размер (в пикселях) области поиска ТО на формируемых изображениях сенсорной и виртуальной видеокамерами в пикселях (размер определяется погрешностями бортовых приборов и размером входных изображений).

- Размер изображений (в пикселях) для ТО (размер определяется разрешением, зашумленностью и смазом (расфокусировкой) реального изображения).

- Порог обнаружения ТО (определяется разрешением, зашумленностью и смазом реального изображения).

На основании пространственной модели местности, модели функционирования виртуальной видеокамеры, характеристик штатной видеокамеры (угловые поля зрения, разрешение в эффективных пикселях) и координат центров значимых ориентиров, формируют синтезированное изображение с пикселями, соответствующими центрам видимых в данный момент ТО с известными пространственными координатами для рассматриваемых объектов (см. Приложение, фиг. 1).

Вокруг центров ТО формируют их изображения следующим образом: вокруг центрального пикселя изображения, переведенного в цветовое пространство оттенков серого (если изображение не монохромное), вокруг пикселя берут окрестность фиксированного размера, где данный пиксель является точкой пересечения диагоналей квадрата (квадратную окрестность пикселя), вычисляют модуль градиента (градиент Собеля дает удовлетворительный результат, см., например, URL: http://habrahabr.ru/post/128753/) для каждого пикселя изображения ТО, затем производят линейную коррекцию яркости изображения ТО. Использование изображений ТО, например, от 15×15 до 31×31 пикселей, обеспечивает достаточную устойчивость к шуму и к дискретизации. Использование модуля градиента изображения, преобразованного в монохромное, обеспечивает инвариантность к цветовым и яркостным составляющим изображений, а оценивание только контрастов перепадов яркостей и конечное применение линейной коррекции - гарантирует устойчивость к несовпадению контрастов при разных способах формирования сопоставляемых изображений. В Приложении на фиг. 2 приведена схема вышеописанного способа формирования изображения ТО.

Затем на сенсорном изображении производят отождествление местоположений ТО, отмеченных на синтезированном изображении. При этом на текущем сенсорном изображении находят предполагаемые области поиска местоположения ТО. Центры областей поиска соответствуют координатам пикселей - центров ТО на синтезированном изображении. Размеры областей поиска определяются погрешностями бортовых навигационных приборов. Целесообразно использовать квадратные окрестности пикселей на сенсорном изображении вокруг априорно известных координат центров ТО с размерами, превышающими размеры изображений ТО. Затем для каждой ТО на синтезированном изображении ищут ей соответствующую ТО такого же размера на сенсорном изображении. Поиск заключается в формировании всевозможных изображений ТО внутри выбранной области и вычислении меры их отклонения от эталонного изображения ТО на синтетическом изображении. Критерием поиска является минимальное значение D - отклонения между сопоставляемыми изображениями ТО фиксированного размера, которое вычисляют по следующей формуле:

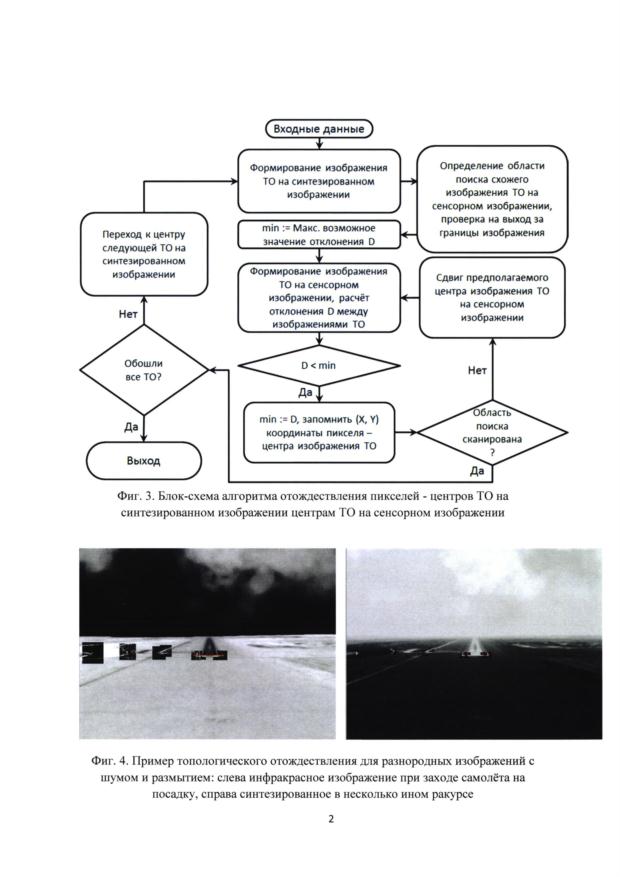

где N - линейный размер по ширине и высоте сопоставляемых изображений ТО, LR(x, y) и LS(x, y) - яркости соответствующих пикселей изображений ТО на сенсорном R и синтезированном S изображениях. В Приложении на фиг. 3 представлена блок-схема описанного алгоритма отождествления.

В ряде случаев искомая ТО может не обнаруживаться на сенсорном изображении, например, из-за погодных условий или времени суток. Для уменьшения ошибки ложного обнаружения искомой ТО выставляют условие максимально возможного минимального значения D в области поиска, исходя из характера входных изображений. Например, достаточно надежный результат дает адаптивное условие, зависящее от максимального max и минимального min значений D в фиксированной области поиска K:

при выполнении этого условия искомая ТО будет учитываться на этапе уточнения местоположения и ориентации виртуальной камеры. Величина указанного весового коэффициента в приведенном условии выбрана авторами эмпирическим путем.

Описанный алгоритм отождествления местоположений ТО позволяет производить устойчивое сопоставление ТО на инфракрасных сенсорных и синтезированных изображениях, соответствующих видимому диапазону (см. Приложение, фиг. 4).

Последующее уточнение местоположения и ориентации виртуальной камеры производят путем минимизации функции невязки расстояний между центрами соответствующих ТО. Функция невязки S(x, y, z, ψ, θ, γ), согласно методу наименьших квадратов, может быть определена как сумма квадратов расстояний между соответствующими пикселями сенсорного и синтезированного изображений. Минимум функции невязки соответствует уточненным значениям параметров внешнего ориентирования виртуальной камеры: положению в пространстве (х, y, z) и углам ориентации (ψ, θ, γ) - курсу, тангажу и крену соответственно.

Функция невязки может быть определена следующим образом:

где Ri.X и Ri.Y - X и Y координаты пикселя Ri, принадлежащего центру найденной ТО на сенсорном изображении, Р{х, y, z, ψ, θ, γ, (Xi, Yi, Zi)} - величина яркости центрального пикселя соответствующей ТО на синтезированном изображении, полученная путем использования оператора перспективного проецирования Р точки (Xi, Yi, Zi) в пространстве 3D модели из положения и ориентации виртуальной камеры (х, у, z, ψ, θ, γ) на синтезированном изображении, N - число точек-центров ТО.

Минимум функции S(x, y, z, ψ, θ, γ) определяют на компактном множестве М={х±δх,у±δy,z±δz,ψ±δψ,θ±δθ,γ±δγ}, где δх, δу, δz, δψ, δθ, δγ - известные максимальные погрешности бортовых приборов по измерению текущего положения и ориентации летательного аппарата. Этот минимум можно определить, используя метод покоординатного спуска (см., например, URL: http://dic.academic.ru/dic.nsf/enc_mathematics/4071/ПОКООРДИНАТНОГО). Блок-схема используемого метода минимизации покоординатным спуском представлена в Приложении на фиг. 5. Используемый метод минимизации сводят к итерационной последовательной одномерной минимизации функции S отдельно по каждому аргументу до тех пор, пока минимизация имеет смысл, то есть пока ее значение на текущем шаге будет меньше, чем на предыдущем шаге итерации, например, с помощью известного метода деления отрезка пополам (см., например, URL: http://eco.sutd.ru/Study/Informat/mpd.html).

Для устранения резких скачков и дрожаний результирующего комбинированного изображения при изменении количества и структуры расположения изображений ТО на паре совмещаемых изображений применяют одномерную фильтрацию по Калману (см., например, URL: http://www.habrahabr.ru/post/166693). При этом для временной фильтрации каждого из параметров ориентирования предполагают, что параметры ориентирования независимы друг от друга. Для такой фильтрации фильтр Калмана может быть представлен в виде:

X0 opt=Z0,

Xt+1 opt=(Xt opt+Ut+ξ)*(1-K)+K*(Zt+η),

где Xt opt, Xt+1 opt - оптимальные значение параметра ориентирования X в текущий момент времени и в следующий за ним,

Ut - модель изменения параметрами ошибка этой модели ξ, σξ 2 - дисперсия ошибки,

Zt - показание параметра ориентирования X, измеренное бортовым сенсором с ошибкой η, ση 2 - дисперсия ошибки,

K - коэффициент фильтра Калмана, вычисляют из соображений минимизации ошибки

e t+1=Xt+1-Xt+1 opt,

где Xt+1=Xt+Ut+ξ - истинное значение параметра ориентирования X, тогда K находят из итерационных формул:

E(e 0 2)=ση 2,

В качестве простейшей модели изменения координаты X при полете ЛА можно использовать соотношение Ut=Zt-Zt-1. В этом случае σξ=ση.

Микширование сенсорных и уточненных синтезированных изображений может выполняться, например, по следующей формуле:

K(х, у)=р*R(x, y)+(1-p)*S(x, y),

х=0, …, М, y=0, …, N, 0≤р≤1,

где K(х, у) - результирующее комбинированное изображение, R(x, y) - сенсорное изображение, S(x, y) - синтезированное изображение, которое получают по схеме, указанной в Приложении на фиг. 1, с использованием уточненного положения и ориентации ЛА, М и N - количество пикселей по ширине и по высоте микшируемых изображений соответственно, р - коэффициент соотношения сенсорного и синтезированного изображения (см., например, фиг. 6 или 7 в Приложении), который может быть настроен вручную или автоматически в зависимости, например, от погодных условий или времени суток.

Программная реализация предлагаемого способа подтверждает его эффективность. На фиг. 6 в Приложении представлен результат работы программной реализации предложенного способа, где имитировалась посадка самолета на аэродром в условиях сильного тумана. Левый верхний кадр на фиг. 6 («Бортовая камера») демонстрирует имитацию изображения, получаемого от бортового сенсора ЛА, с неизвестными точными параметрами внешнего ориентирования, которые используются для оценки невязки показаний бортовых приборов. Правый верхний кадр («Бортовая ЭВМ») - проекция 3D модели местности, соответствующая текущим показаниям навигационных бортовых приборов. Левый нижний кадр («Наложение данных») показывает несоответствие «сенсорного» и сформированного «синтезированного» изображений. Правый нижний кадр и уточненные параметры внешнего ориентирования справа от него - результат работы реализации предлагаемого способа. На нижних цифровых изображениях выделены центры ТО, по которым и осуществляется совмещение. Как видно из рассмотрения фиг. 6 Приложения, совмещение изображений с точностью до одного пикселя существенно снижает погрешности бортовых приборов по положению и ориентации. В примерах (см. фиг. 6, 7 Приложения) в качестве ошибок навигационной системы были выбраны случайные нормально распределенные величины со среднеквадратическими отклонениями (СКО), равными 1° по углам ориентации, 10 м по координатам X и Ζ в пространстве и 20 м по пространственной координате Υ, что соответствует погрешностям реальных навигационных приборов (см., например, Костяшкин Л.Н., Логинов Α.Α., Никифоров М.Б. Проблемные аспекты системы комбинированного видения летательных аппаратов // Известия ЮФУ. 2013. №5. С. 61-65). Невязку по координатам вычисляют как евклидово расстояние между положением «бортовой» («сенсорной») и виртуальной камер ЛА. Невязку по ориентации вычисляют как сумму модулей разности между соответствующими углами ориентации бортовой и виртуальной видеокамер. Точками на нижних кадрах изображений подстилающей поверхности помечены центры ТО, используемые для совмещения изображений.

Результат работы программной реализации заявляемого способа при отключенных текстурах в пространственной модели местности и минимальном числе ТО, используемых для совмещения, представлен на фиг. 7 Приложения.

Литература

1. Лебедев М.А., Бондаренко М.А., Комаров Д.В., Степаньянц Д.Г., Выголов О.В., Визильтер Ю.В., Желтов С.Ю. Алгоритм автоматического совмещения сенсорной и синтезируемой видеоинформации для авиационной системы комбинированного видения // Вестник компьютерных и информационных технологий. 2014. №7, URL:

http://www.vkit.ru/index.php/component/content/article/60-2014-07--july/267-008-013

2. Способ совмещения сенсорной и синтетической информации в комбинированное изображение, патент США US 7925117 В2 от 27 июня 2006 года, URL: http://www.google.com.ar/patents/US7925117

3. Оператор Собеля, URL: http://habrahabr.ru/post/128753/

4. Метод покоординатного спуска, URL:

http://dic.academic.ru/dic.nsf/enc_mathematics/4071/ПОКООРДИНАТНОГО

5. Метод деления отрезка пополам, URL: http://eco.sutd.ru/Study/Informat/mpd.html

6. Фильтр Калмана, URL: http://www.habrahabr.ru/post/166693/

7. Шикин Е.В., Боресков А.В. Компьютерная графика. Полигональные модели. - М.: Диалог-МИФИ, 2001. - 464 с.

8. Костяшкин Л.Н., Логинов А.А., Никифоров М.Б. Проблемные аспекты системы комбинированного видения летательных аппаратов // Известия ЮФУ. 2013. №5. С. 61-65, URL: http://izv-tn.tti.sfedu.ru/wp-content/uploads/2013/5/11.pdf

Формула изобретения

1. Способ получения на летательном аппарате (ЛА) улучшенного изображения подстилающей поверхности, основанный на совмещении в бортовом компьютере ЛА сенсорной видеоинформации, полученной с помощью штатной видеокамеры ЛА, и синтезированной видеоинформации, сформированной по априорно заданной пространственной модели местности, введенной в память бортового компьютера, характеризующийся тем, что в память бортового компьютера вводят алгоритм функционирования виртуальной видео камеры, осуществляющий перспективное преобразование виртуальной модели местности на картинную плоскость с параметрами, соответствующими угловым размерам поля зрения и разрешению в эффективных пикселях штатной видеокамеры, а в каждый текущий момент времени в бортовой компьютер ЛА вводят соответствующую сенсорную видеоинформацию и информацию о пространственном положении штатной видеокамеры (широта, долгота, высота, углы ее ориентации), по которой определяют параметры перспективного проецирования местности, затем на основе этих данных по пространственной модели местности формируют соответствующее текущее синтезированное изображение, на котором определяют и отмечают местоположение не менее двух известных топологических особенностей (ТО), заданных в априорно введенной пространственной модели местности, затем на сенсорном изображении находят местоположения ТО, тождественных ТО, отмеченных на синтезированном изображении, после чего сопоставляют положения найденных ТО на сенсорном изображении и соответствующих ТО на синтезированном изображении, выявляют невязки расстояний между центрами соответствующих ТО и по выявленным различиям уточняют пространственное положение виртуальной видеокамеры за счет проведения процедуры минимизации функции суммарной невязки этих расстояний, затем производят временную фильтрацию уточненного пространственного положения с учетом предшествующих уточненных значений, с последующим формированием с помощью виртуальной камеры нового синтезированного изображения, а потом, суммируя сенсорное и новое синтезированное изображение, формируют микшированное представление подстилающей поверхности, которое и выводят на индикаторное устройство ЛА.

2. Способ по п. 1, отличающийся тем, что при получении изображений ТО, априорно заданных на пространственной модели местности, применяют линейную коррекцию динамического диапазона в окрестности центров ТО на сенсорном и синтезированном изображениях.

3. Способ по п. 1, отличающийся тем, что временную фильтрацию уточненных пространственных положений виртуальной видеокамеры осуществляют, используя процедуру фильтрации по Калману.

ИЗВЕЩЕНИЯ

MM4A Досрочное прекращение действия патента из-за неуплаты в установленный срок пошлины за поддержание патента в силе

Дата прекращения действия патента: 14.02.2018

Дата внесения записи в Государственный реестр: 18.12.2018

Дата публикации и номер бюллетеня: 18.12.2018 Бюл. №35